2013

Ciência

Ciência O Cientista

ALBERT EINSTEIN (1879 – 1955) Einstein foi um dos físicos teóricos com maior impacto a nível mundial, não só do ponto de vista científico como também social, tornando-se o cientista mais popular do Mundo e, talvez o único cuja fotografia é geralmente reconhecida sem hesitação. Einstein é responsável pela elaboração de diversas formulações que mudaram a forma de ver o espaço, o mundo e a energia. Os seus trabalhos teóricos foram contributos essenciais, por exemplo, para o desenvolvimento da energia nuclear e a compreensão das leis da física associadas ao Big Bang. Tornou-se amplamente popular pela sua fórmula de equivalência entre massa e energia, E = mc2 (que costuma ser considerada a equação mais famosa do mundo); esta equação significa que a energia (E) é igual à massa (m) multiplicada pelo quadrado da velocidade da luz (c). Em 1921 foi-lhe atribuído o Prémio Nobel da Física “pelos seus serviços à Física Teórica, e especialmente pela descoberta da lei do efeito fotoelétrico”, sendo que as suas descobertas foram fundamentais para estabelecer a teoria quântica. Apesar de pacifista estava consciente de que avanços na compreensão das reacções nucleares em cadeia poderiam levar os alemães a conseguir fabricar uma bomba atómica. Por isso em 1939 alerta o Presidente Roosevelt para a necessidade dos Estados Unidos da América desenvolverem esforços intensos nesse domínio; pouco depois iniciava-se o projecto Manhattan que viria a produzir as bombas atómicas lançadas sobre o Japão em 1945. No fim da vida arrepender-se-ia de ter enviado esta carta tendo sido um dos principais signatários do chamado manifesto Russel-Einstein que alertava para os perigos da proliferação de armamento nuclear e no qual se apelava aos líderes mundiais que procurassem soluções pacíficas para os conflitos internacionais. A sua importância a nível científico levou também a que o seu nome fosse atribuído a um elemento químico (Einsténio). Este elemento químico sintético (pertencente ao grupo dos actinídios) foi descoberto em 1952 durante o ensaio nuclear Ivy Mike realizado pelos Estados Unidos num atol no Pacífico. O Conceito

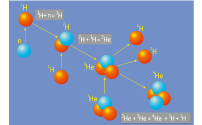

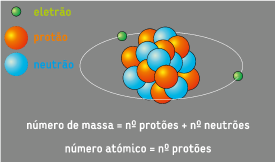

DO BIG BANG À TABELA PERIÓDICA; UM PROCESSO COMPLEXO  Desde o Big Bang, há cerca de 14.000 milhões de anos, que o Universo tem sofrido profundas transformações. Em 1929 Edwin Hubble verificou que as galáxias se afastam umas das outras e que essa velocidade aumenta com a distância; o Universo encontrava-se por isso em expansão. Assim, se recuarmos ao momento inicial, o Universo estaria condensado num ponto. O decréscimo da temperatura associado ao começo da expansão inicial permitiu que a energia começasse a ser convertida em diversas partículas sub-atómicas, incluindo protões, neutrões e eletrões; estava dado o primeiro passo para a formação dos elementos químicos.  O hidrogénio (com apenas um protão no núcleo) foi o primeiro elemento a formar-se; seguiu-se um dos seus isótopos estáveis, o deutério que possui mais um neutrão no núcleo. O contínuo processo de arrefecimento facilitou a interação entre as partículas, tendo-se originado os primeiros núcleos de Hélio. Entrou-se então num impasse pois o núcleo de Hélio é extremamente estável. A matéria estaria então sob a forma de um plasma formado por núcleos estáveis de elementos leves, misturados com eletrões livres. Há medida que a temperatura decrescia os eletrões e os núcleos atómicos começam a combinar-se, formando então átomos eletricamente neutros. A força da gravidade foi a responsável pela etapa evolutiva seguinte. Devido à presença de heterogeneidades na distribuição de matéria, a ação da gravidade irá condicionar o aparecimento das galáxias. As próprias galáxias apresentavam também heterogeneidades da distribuição espacial da matéria de que resultam as estrelas. Foi nas estrelas que se reiniciaram os processos nucleares permitindo gerar os núcleos dos restantes elementos químicos. A elevada concentração de matéria na região onde se iria formar uma nova estrela induziu incrementos brutais da temperatura e pressão. A temperatura que era então atingida dependia essencialmente da massa da estrela que estava a colapsar, condicionando o tipo de reações nucleares possíveis no núcleo da estrela. Os processos de fusão nuclear que aí ocorriam permitem explicar a formação dos elementos até ao número atómico do Ferro. Contudo, os núcleos de Ferro são muito estáveis entrando-se num novo impasse; a formação de restantes elementos da tabela periódica terá por isso de ser explicada à luz de outros processos. O colapso da massa que constituía a estrela é impedido pela produção de energia nas reações nucleares que ocorriam no seu interior e que se "opõem" à força gravítica. No entanto, à medida que o "combustível" da estrela vai sendo consumido com a génese de elementos com maior número de protões e neutrões, ocorre a diminuição da energia produzida. Sem nada que se oponha ao processo de colapso gravítico, a sua contração é retomada levando ao colapso e explosão da estrela com a génese de uma supernova; grande parte da matéria produzida durante este processo de evolução será então lançada para o espaço criando-se as condições para a génese dos núcleos de maiores dimensões.

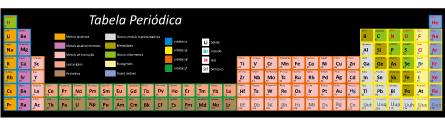

Aplicação

Da tabela Periódica à(s) Energia(s) O que têm em comum os ossos, um mármore, o leite e a cal? Todos estes materiais apresentam na sua constituição átomos de Cálcio. Mas o que é um átomo!? Todas as substâncias são formadas por partículas de dimensões muito pequenas (nanométricas) que apresentam características químicas e físicas próprias. Um átomo pode assim ser considerado a unidade básica da matéria, podendo ser dividido num núcleo central (de carga positiva) envolto numa nuvem de electrões (de carga negativa). O núcleo, por sua vez, é constituído por protões (que fornecem a carga positiva ao átomo) e neutrões. A classificação dos átomos dos diversos elementos químicos é feita tendo em conta o número de protões presentes no seu núcleo (número atómico). A existência de regularidades periódicas nas propriedades dos elementos químicos, aliada à necessidade de sistematizar toda a informação disponível, levou ao desenvolvimento da chamada Tabela Periódica. Esta sistematização dispõe os 118 elementos actualmente identificados por ordem crescente de número atómico, em linhas horizontais (períodos) e verticais (grupos). Um conjunto de átomos pode estar ligado entre si através de ligações químicas, formando compostos químicos. Diferentes compostos podem reagir entre si quebrando as ligações existentes e estabelecendo novas ligações. A este fenómeno dá-se o nome de reacção química, sendo que as substâncias que reagem entre si se designam de reagentes e as que resultam da reacção de produtos. Uma reacção química envolve sempre um balanço energético entre a energia consumida na criação das novas ligações e a energia necessária para quebrar as ligações dos produtos. Esta variação da energia do sistema é designada de variação da entalpia (?H). Consoante a reacção liberte ou absorva energia, então esta pode definir-se como exotérmica ou endotérmica, respectivamente. Nas reacções endotérmicas, os produtos de reacção possuem uma energia superior à dos reagentes. Nesta tipologia de reacções, a energia consumida na criação das novas ligações é maior do que a energia necessária para quebrar as ligações dos reagentes; quando a reacção ocorre dá-se uma diminuição da temperatura do sistema. Desta forma, o balanço energético é positivo, ou seja, houve mais absorção de energia durante a reacção do que libertação; assim, a variação da energia possui sinal positivo (+ΔH). Das reacções exotérmicas resulta a libertação de energia no decorrer da reacção, sob a forma de calor. Neste caso, os reagentes têm uma energia superior à energia dos produtos, ou seja, a energia utilizada na ruptura das suas ligações é maior que a energia produzida aquando da formação das novas ligações; quando a reacção ocorre dá-se um aumento da temperatura do sistema. O balanço energético das reacções exotérmicas é por isso negativo (-?H), ou seja, houve mais libertação de energia do que absorção de energia do sistema. O Cientista

ARQUIMEDES (287 a.C. – 212 a.C.) Arquimedes é sem dúvida um dos mais conhecidos cientistas da Antiguidade, o que se deverá essencialmente ao célebre EUREKA que terá gritado enquanto corria nu pelas ruas após ter descoberto o princípio da impulsão e a sua relação com a densidade dos materiais. Mas, a sua importância ultrapassa em muito esta descoberta; o Parafuso de Arquimedes (uma forma eficiente de bombear água que ainda hoje é utilizada), o princípio das Alavancas (será sua a frase "dêem-me um ponto de apoio e moverei o Mundo") e sua aproximação ao valor de p (pi) que foi utilizada durante toda a Idade Média, são apenas alguns dos seus imensos contributos no desenvolvimento do Conhecimento. Nem sempre é fácil separar a realidade dos Mitos no trabalho deste sábio grego. Alguns dos mais conhecidos relacionam-se com máquinas de guerra que terá inventado, durante a segunda guerra púnica entre Roma e Cartago, para proteger dos navios romanos a cidade-estado de Siracusa onde vivia. Durante o cerco, para além de catapultas e uma Mão de Ferro que permitia levantar e afundar os navios que se aproximavam dos muros da cidade terá ainda, segundo alguns relatos, criado o Raio da Morte ou Raio do Calor. Este raio seria produzido pela concentração da radiação solar num ponto o que seria conseguido utilizando uma série de espelhos (ou escudos de cobre polidos?) eventualmente côncavos; quando os raios solares eram concentrados num navio inimigo a madeira de cedro de que eram feitos incendiar-se-ia em pouco tempo levando ao seu afundamento. Mas vários historiadores e cientistas modernos divergem quanto à possibilidade de Arquimedes ter realmente utilizado o Raio da Morte. Tentando resolver este dilema, nos últimos anos algumas experiências tentaram recriar o que se poderia ter passado:

No entanto, quer tenha ou não sido utilizado o Raio da Morte, Siracusa acabaria por cair nas mãos dos romanos e Arquimedes seria morto por um soldado inimigo após a conquista, apesar das ordens para não o matarem, devido à admiração que os líderes romanos tinham por ele. Também aqui a História se mistura com a ficção e vários relatos persistem sobre a sua morte. Segundo uns terá sido morto por se ter recusado a acompanhar o soldado pois estava a terminar um raciocínio geométrico; segundo outros, foi morto por o soldado julgar que os instrumentos científicos que Arquimedes transportava seriam valiosos. O Conceito

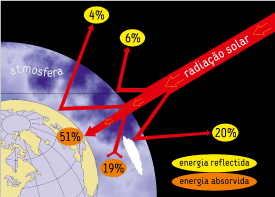

Radiação solar; uma viagem de 150 milhões de quilómetros O Sol pode ser considerado um gigantesco reator de fusão nuclear em permanente atividade. A energia gerada nessas reações propaga-se até à superfície solar, cuja temperatura se estima ser da ordem dos 5788 K e a partir daí difunde-se para o espaço sob a forma de radiação (ondas eletromagnéticas). Qualquer superfície cuja temperatura esteja acima do zero absoluto (0 K = -273ºC) emite (e absorve) energia sob a forma de radiação (radiação térmica). A taxa (potência) de energia radiada nessas condições é proporcional à área da superfície radiante e à quarta potência da sua temperatura. Esta relação é dada pela lei Stefan-Boltzman: Pr = esAT4 onde Pr = Potência total irradiada (Watt); e = emissividade do corpo radiante, grandeza que depende da composição da superfície (varia entre 0 e 1); s = constante de Stefan-Boltzman (5,6703 x 10-8 W /m2.K4); T = temperatura em Kelvin. Desta forma, se considerarmos que o sol radia como um corpo negro (e = 1) e tendo em consideração a temperatura da sua superfície, facilmente se calcula que a potência irradiada por cada metro quadrado dos cerca de 6.1x 1018 que constituem a superfície do Sol é 65MW (cerca de metade da potência da central hidroelétrica de Castelo de Bode). Se um corpo emite mais radiação do que a que recebe a sua temperatura cai; se o corpo absorve mais radiação do que a que emite, então o corpo fica mais quente. Esta relação entre a radiação emitida/absorvida pelos corpos e as variações de temperatura que sofrem, é um processo de transferir calor. Ao contrário dos outros processos de transferência de calor (convecção e condução) que dependem de átomos, moléculas ou eletrões para transportar o calor, a radiação ocorre diretamente através do espaço, mesmo quando não exista matéria entre os objetos (no vazio ela propaga-se à velocidade de cerca de 300 000 km/s). A radiação solar é pois um processo extremamente eficiente na contínua transferência de energia para a Terra e um dos principais responsáveis pela manutenção da dinâmica deste planeta. Perceber o delicado equilíbrio que existe entre a temperatura existente à superfície da Terra e a radiação solar que a atinge, implica olhar para este processo com um pouco mais de atenção. A radiação que resulta deste processo de transporte de energia apresenta um espectro contínuo, contudo com potência diferente nos vários comprimentos de onda; a lei de Wien relaciona a temperatura (T) do emissor com o comprimento de onda da radiação que tem potência máxima no espectro (lmax = 2.898/T). Nem toda a radiação solar que atinge o nosso planeta consegue ser absorvida pela sua superfície e pela atmosfera que o envolve. Com efeito, cerca de 6% é imediatamente refletida pela atmosfera, 20% pelas nuvens e 4% pela própria superfície; esta radiação que é refletida constitui o denominado albedo da Terra que, atualmente atinge os 30%. No que diz respeito aos 70% da radiação solar que não é refletida, 51% é absorvida pela Terra e 19% pela sua atmosfera. Se não houvesse nenhum processo que compensasse esta contínua entrada de radiação, a superfície do nosso planeta e a atmosfera envolvente estariam permanentemente a aquecer. Mas, como vimos, qualquer corpo acima do zero absoluto emite radiação. No caso da Terra, cuja temperatura média à superfície é de cerca de 15º C, a radiação é essencialmente emitida sob a forma de ondas longas, no domínio do chamado infravermelho. Aplicação

Transferências de Calor; os mecanismos principais Mesmo nos cristais perfeitos que possuem uma estrutura interna ordenada, a posição estrutural dos átomos na malha cristalina nunca é perfeitamente fixa devendo antes ser considerada do ponto de vista estatístico. Com efeito, exceto para temperaturas próximas do zero absoluto (isto é 273ºC negativos), os átomos vibram com amplitudes e direções bem definidas pela estrutura e pela temperatura. Por isso, a generalidade das representações das malhas cristalinas mostram apenas os átomos na posição mais provável, em torno da qual vibram. A esta vibração das partículas constituintes da matéria (átomos no caso das redes cristalinas ou moléculas no caso de gases), designada por agitação térmica, está associada uma energia: a energia térmica dos materiais. A energia térmica transfere-se se uns materiais para outros, fenómeno designado por calor, segundo três processos:

O Cientista

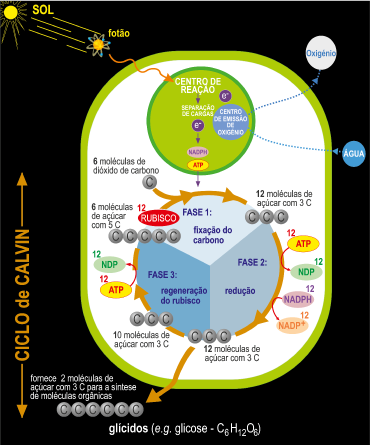

MELVIN CALVIN (1911 – 1997) A fotossíntese é sem dúvida o processo bioquímico mais importante do nosso planeta que, não só está na origem de toda a fonte de energia da nossa alimentação, mas também na base de quase toda a eletricidade e calor que utilizamos diariamente nas nossas atividades. Sem ela a evolução da Vida na Terra, teria seguido um caminho completamente diferente e, sem dúvida que não estaríamos agora aqui. A equação geral da fotossíntese, que ocorre em presença de luz e clorofila, é enganadoramente simples...

6CO2 + 12H2O à C6H12O6 + 6O2 + 6H2

dióxido + água → glicose + Oxigénio de carbono + hidrogénio ...com efeito, um conjunto extremamente complexo de reações físicas e químicas ocorrem de forma coordenada para a síntese de hidratos de carbono e outros compostos orgânicos, libertando no processo como subprodutos oxigénio e hidrogénio. Os fundamentos deste ciclo de reações foram desvendados ao longo de mais de uma década de investigação de uma equipa da Universidade de Berkeley na Califórnia liderada por Melvin Calvin, onde desempenharam também um papel de destaque Andrew Benson e James Bassham. Nas experiências então realizadas, utilizaram um dos isótopos do carbono que é radioativo (o chamada carbono catorze, C14) como marcador no dióxido de carbono absorvido pelas plantas. A possibilidade de seguirem o percurso deste isótopo durante todo o processo da fotossíntese, desde a absorção do dióxido de carbono atmosférico até à sua conversão em compostos orgânicos, permitiu-lhes demonstrar que a luz solar interagia com a clorofila (e não com o dióxido de carbono como até então se pensava) para produzir os compostos orgânicos. Foi então possível perceber que o processo fotossintético ocorre somente nos cloroplastos, estruturas sub-celulares contidas nas células das folhas, caules verdes e em todos os tecidos de algas. O trabalho liderado por Melvin em Berkeley, publicado pela primeira vez em 1950, mudou radicalmente a compreensão científica da fotossíntese. Em particular permitiu a compreensão da chamada fase escura deste processo, elucidando a cadeia cíclica de reações complexas em que enzimas transformam o dióxido de carbono em glícidos, tais como a sacarose, a celulose ou o amido. A importância científica deste processo que ficou conhecido como ciclo de Calvin (por vezes também designado por ciclo de Calvin - Benson - Bassham) levou a que em 1961 fosse atribuído a Calvin o Prémio Nobel da Química. Calvin não era um cientista comum, possuindo uma curiosidade enorme, em especial na área da química que o levava já em jovem a investigar a composição química de todos os produtos da mercearia dos seus pais. Esta curiosidade nunca o deixou, levando-o a aventurar-se por investigações em áreas tão diversificadas como a carcinogénese, a evolução química e a origem da vida, a geoquímica orgânica, a imunoquímica, a produção de petróleo a partir de plantas ou mesmo o desenvolvimento de novos modelos sintéticos de membranas para fotossistemas vegetais. A necessidade de uma enorme interdisciplinaridade na investigação destas novas áreas, levou-o a projetar para a Universidade de Berkeley um laboratório de biodinâmica química em forma circular, o chamado Carrossel de Calvin inaugurado em 1964, como forma de promover uma comunicação contínua entre os investigadores. O Conceito

FOTOSSÍNTESE; um processo a dois tempos A radiação solar que constantemente chega à Terra é fundamental para a Vida no nosso planeta. Para que isso aconteça é necessário um processo que a permita transformar a radiação solar numa forma energética que todos os seres vivos possam utilizar. Os chamados seres fotoautotróficos (as plantas, as algas e as cianobactérias) desenvolveram um mecanismo que lhes permite captar esta radiação, conjuntamente com moléculas de dióxido de carbono e água, e convertê-la em energia química num processo denominado fotossíntese. Esta nova forma de energia consegue já ser utilizada por todos os seres vivos, incluindo os que não realizam fotossíntese e que por isso se denominam heterotróficos (como por exemplo, animais, fungos, e quase todas as bactérias). A fotossíntese corresponde na realidade a duas fases. Na primeira fase, dependente diretamente da luz a clorofila (pigmento responsável pela cor verde dos seres fotossintéticos) absorve fotões da radiação solar permitindo um conjunto de transformações, onde são produzidos o NADPH (um agente redutor químico) e o ATP (a molécula de energia biológica), libertando-se como subproduto o oxigénio, resultante da cisão da molécula de água. Em conjunto o NADPH e o ATP fornecem energia para a segunda etapa da fotossíntese (fase não dependente directamente da luz). Esta segunda parte do processo fotossintético, caracteriza-se por um conjunto de reações cíclicas que transformam o dióxido de carbono atmosférico e um açúcar constituído por cinco átomos de carbono em açúcares cujas moléculas contêm apenas 3 átomos de carbono. Uma parte destes açúcares são reintroduzidos no ciclo, enquanto o resto é utilizado para formar os glúcidos (hidratos de carbono), como por exemplo, a sacarose, a celulosa ou o amido, constituintes essenciais ao desenvolvimento dos seres vivos. Os detalhes deste último complexo conjunto de reações foram descobertos por uma equipa chefiada por Melvin Calvin e, por isso este ciclo é normalmente conhecido por Ciclo de Calvin.  Embora a fotossíntese nas plantas e nas algas ocorra em organelos (cloroplastos) com apenas alguns micra de diâmetro, este processo tem um profundo impacto na Terra. Cada ano, mais de 10% do total do dióxido de carbono da atmosfera é convertido em glúcidos pelos organismos fotossintéticos. A maior parte deste carbono, que se encontra na forma reduzida é devolvido para a atmosfera, quer através do metabolismo dos seres vivos, quer por combustão da biomassa atual ou dos combustíveis fósseis que são o resultado de processos fotossintéticos ocorridos no passado geológico da evolução do nosso planeta. Aplicação

Da Fotossíntese à bioenergia A biomassa abrange a fração biodegradável de produtos e resíduos da agricultura (incluindo substâncias vegetais e animais), da silvicultura e das indústrias afins, bem como a fração biodegradável dos resíduos industriais e urbanos. A sua aplicação é bastante antiga e extensa, por exemplo, a lenha (biomassa) é utilizada como combustível desde que o homem descobriu o fogo. Atualmente, a possibilidade de se utilizarem materiais que até então eram considerados "lixo" como matéria-prima para biocombustíveis atrai imensas expectativas. Para além da madeira, em termos energéticos é possível dividir a biomassa, em biocombustíveis e biogás. O biogás, é o nome dado a um combustível gasoso obtido pela digestão anaeróbia de compostos orgânicos (resíduos), plantas mortas e material animal, esterco animal, restos de cozinha, etc. Este biogás é obtido usando digestores anaeróbicos, em que um reservatório de ar transforma resíduos de biomassa em metano que pode ser usado para o aquecimento e a produção de eletricidade, principalmente no meio rural. Nalguns aterros sanitários, por exemplo, utiliza-se o metano (CH4), para através dele, gerar eletricidade. No entanto, a utilização de alimentos para a produção de biocombustíveis está longe de ser pacífica visto contribuir para a subida dos seus preços. Esta situação levou o Parlamento Europeu em setembro de 2013 a limitar a utilização deste tipo de combustíveis a um máximo de 6% do consumo europeu; esta medida irá provocar o recuo do desenvolvimento deste tipo de combustíveis e o previsível fecho de algumas das fábricas. O Cientista

James Watt (1736 – 1819) Entre 1760 e 1840 houve uma mudança radical no funcionamento das Sociedades que ficou conhecida por Revolução Industrial. A produção dos bens de consumo, que até então era essencialmente artesanal, deu origem a grandes unidades fabris, onde um grande número de pessoas trabalhavam integradas em longas cadeias de produção em série. Esta profunda transição só foi possível pela introdução generalizada de maquinarias que mecanizaram a produção dos artigos, que até então eram essencialmente manufaturados. Estas novas máquinas utilizavam quase sempre a energia resultante da combustão do carvão para vaporizar a água gerando vapor que era utilizado para colocar as máquinas em movimento. O sucesso da Revolução Industrial assentou na descoberta e desenvolvimento de máquinas a vapor cada vez mais eficientes e, nessa caminhada uma pessoa viria a desempenhar um papel-chave... James Watt. Filho de pai carpinteiro naval, James Watt não conseguiu frequentar a escola primária devido à sua débil saúde, tendo recebido aulas em casa de sua mãe. Cedo se interessou pelo fabrico de instrumentos que utilizavam motores a vapor. Aos 16 anos, partiu para Glasgow em busca de trabalho tendo sido aprendiz numa fábrica. Aos 19 anos foi para Londres como aprendiz de mecânico especializado na construção de instrumentos, mas em menos de um ano regressou à Escócia, devido a problemas de saúde. De volta a Glasgow, decidiu trabalhar por conta própria e abriu uma loja de instrumentos. Esta sua invenção impulsionou também a metalurgia e a construção das primeiras locomotivas a vapor, que viriam a revolucionar completamente o sistema de transportes. Patenteou ainda outras invenções importantes, incluindo o motor rotativo, o motor de dupla ação e um indicador de vapor que permitia registar a pressão do vapor dentro das máquinas. O Conceito

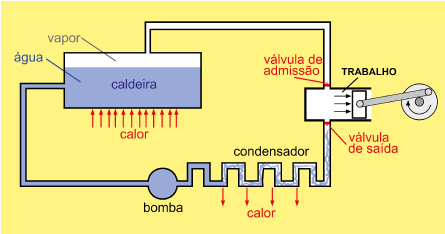

O Triunfo do Calor Até há cerca de 250 anos, a maior parte do trabalho era feito por pessoas ou animais. O vento e a água eram também usados para produzir trabalho, contudo não eram fontes de energia de confiança por não poderem ser usados facilmente em qualquer local e quando necessários. No século XVIII a exploração das reservas de carvão fez surgir a necessidade de um método económico para bombear a água das minas que, doutro modo, ficariam inundadas e teriam de ser abandonadas. A máquina a vapor desenvolveu-se inicialmente para fazer face a esta necessidade prática. A máquina a vapor é um dispositivo mecânico que converte a energia de alguns combustíveis (por exemplo a energia química do carvão ou do petróleo) em calor e este em trabalho. Às máquinas com este atributo, transformar calor em trabalho, chamam-se máquinas térmicas. Numa máquina a vapor típica:

De forma geral as máquinas térmicas funcionam ciclicamente utilizando um fluido de trabalho (água na máquina a vapor ou uma mistura de ar e gasolina num motor de combustão) que absorve uma quantidade de calor (Qq) de um reservatório a alta temperatura (reservatório quente), convertem uma parte desse calor em trabalho (W) que realizam sobre o exterior e voltam ao estado inicial devolvendo o calor não convertido (Qf) ao exterior (reservatório frio). Atendendo a que tanto o calor como o trabalho são formas de energia, podemos representar o trabalho realizado por uma máquina através da equação: W = Qq - Qf

A eficiência de uma máquina (ou rendimento) é o quociente entre o trabalho realizado pela máquina e o calor que é preciso fornecer-lhe: W/Qq. Se fosse possível transformar todo o calor em trabalho, isto é não devolver calor à fonte fria (Qf = 0), teríamos (W = Qq) e consequentemente uma eficiência igual a 1 (100%).O estudo relativo ao aumento da eficiência das máquinas a vapor e o insucesso em se conseguirem bons rendimentos deu origem às primeiras declarações da Segunda Lei da Termodinâmica que enuncia:

Aplicação

Carvão & Petróleo; o carbono orgânico "enterrado! De acordo com o bioquímico Robert Berner da Universidade de Yale, há cerca de 26 000 vezes mais carbono orgânico "morto" aprisionado na crusta terrestre do que em toda a biosfera viva. Toda esta impressionante quantidade de compostos de carbono teve origem em antigos seres vivos que, após terem sido incorporados nos sedimentos depois da sua morte, sofreram um conjunto de processos que acabaram por os transformar em materiais rochosos, dos quais dependemos profundamente em termos energéticos (e.g. carvão e petróleo). Apesar de algumas semelhanças quanto à génese, a formação destes materiais apresenta diferenças fundamentais. CARVÃO Ao longo dos últimos 400 milhões de anos frequentemente as zonas baixas e húmidas dos continentes estiveram cobertas por vastas florestas que, através do processo fotossintético utilizavam grandes quantidades de dióxido de carbono da atmosfera (CO2) transformando-o em glúcidos (i.e. hidratos de carbono), como a celulose (C6H10O5) que é um dos principais constituintes das paredes celulares das plantas (cerca de 1/3 do peso da planta). Após a sua morte, algumas destas plantas acabaram enterradas em ambientes estagnados e pobremente oxigenados o que preservou a matéria orgânica de ser biodegradada e oxidada; com o passar do tempo, novas camadas se foram depositando por cima. Levadas para a profundidade pelo continuar deste processo, os restos dos vegetais foram sendo sujeitos a pressões e temperaturas cada vez maiores. Este longo processo leva a que a matéria orgânica vá perdendo enormes quantidades de água e voláteis orgânicos, promovendo o empobrecimento relativo em oxigénio, azoto e hidrogénio e o enriquecimento relativo em carbono. Este processo designa-se por incarbonização e vai originando materiais rochosos cada vez mais enriquecidos em carbono, segundo uma sequência que revela um aumento do poder calórico acentuado:

Deste modo, quando se queima carvão subterrâneo a energia libertada no processo, acaba por ser parte da radiação solar capturada pelas plantas que originaram o carvão e que tinha ficado aprisionada na estrutura, por vezes durante algumas centenas de milhões de anos. PETRÓLEO Há milhões de anos plantas (normalmente algas) e animais (normalmente zooplâncton) marinhos absorveram energia do Sol ou dos alimentos e acumularam-na sobre a forma de compostos orgânicos. Após a sua morte, os seus corpos caíram para o fundo e foram sendo cobertos por sedimentos ficando sujeitos a condições anaeróbicas. A sobreposição de novas camadas de sedimentos vai aumentando a pressão e a temperatura sobre os restos orgânicos. Com o passar do tempo, a matéria orgânica transformou-se em compostos ricos em carbono, utilizando o oxigénio dissolvido nos sedimentos; a temperatura e pressão a que foram sujeitos, bem como o tipo de biomassa, determinam se o processo irá originar petróleo ou gás natural. Os hidrocarbonetos gerados na rocha-mãe (i.e. uma rocha sedimentar com muita matéria orgânica e com condições de produzir grandes quantidades de hidrocarbonetos) deslocam-se através de rochas mais porosas para outras onde se concentram, pelo que são designadas por rochas-reservatórios. Estas quando devidamente cobertas por rochas impermeáveis, estão deformadas por movimentos tectónicos, podem reter os hidrocarbonetos formando acumulações ou jazigos de petróleo. Os Cientistas

PIERRE PERRAULT (1608 – 1680) & EDMÉ MARIOTTE (1620 – 1684) Na Grécia Antiga e na Cosmologia Bíblica acreditava-se que os continentes flutuavam sobre uma massa de água e julgava-se ser aí a origem da água que circulava nos rios. No entanto, entre 500 a.C. e 350 a.C. já se especulava que os rios poderiam ser alimentados não só através do sub-solo, mas também pela água das chuvas, começando por isso a haver a noção de um ciclo fechado da água no nosso planeta; tanto Platão como Aristóteles foram dois dos filósofos que abordaram a percolação da água da chuva durante este ciclo. Durante o Renascimento a aproximação mais quantitativa / experimental que começou então a ser utilizada na análise dos processos naturais levou muitos a questionar se a água da chuva por si só seria suficiente para manter o fluxo de água nos rios. Nesta linha de pensamento, Bernard Palissy publicou em 1580 um artigo no qual defendia esta possibilidade; no entanto, a ausência de dados quantitativos que sustentassem esta sua conclusão, levou a que a dúvida fosse ainda permanecer por muito tempo.Com efeito, apenas no século XVII Pierre Perrault e Edmé Mariotte determinaram quantitativamente a precipitação na bacia hidrográfica do Sena assim como o caudal que fluía anualmente ao longo deste rio; constataram para sua surpresa que a precipitação era seis a sete vezes superior ao caudal do rio. Estava assim definitivamente provado que origem da água que fluía nos rios provinha da precipitação atmosférica, tendo estes dois cientistas sido responsáveis por transformarem a hidrologia numa ciência experimental Pierre Perrault nasceu numa família burguesa em Paris, estudou advocacia e em 1654 era tesoureiro das finanças em Paris. Responsável pela cobrança de impostos durante o reinado de Luís XIV, perdeu esta posição quando este rei decidiu pela remissão dos contribuintes devedores. Em 1664 Pierre faliu, tornando-se então num cientista amador focando a sua atenção na origem das nascentes, trabalho que resultou em 1674 na publicação D’Origine des Fontains. Perrrault relacionou então a distribuição da água da chuva com os processos de evaporação, transpiração, escorrência e infiltração e levando a considerá-los a fonte de recarga para as águas subterrâneas. Edmé Marriotte foi padre e físico e um dos membros fundadores da Academia de Ciências de Paris criada por Luís XIV em 1666. O trabalho de Marriotte focou-se em grande parte no estudo da óptica e na percepção da cor, mas foi a descoberta do ponto cego que o levou a ser considerado como pioneiro da neurofisiologia. Foi ainda um forte impulsionador da física experimental e um investigador activo em diferentes áreas científicas como a física, a mecânica dos sólidos, a hidráulica, a fisiologia das plantas e a meteorologia. Em 1660 estabeleceu uma lei sobre a deformação elástica dos sólidos e em 1976 reconheceu a Lei de Boyle que é frequentemente referida como Lei de Boyle – Mariotte. O Conceito

CICLO HIDROLÓGICO; EQUILÍBRIO DELICADO QUE TENDE A PERPETUAR-SE NO TEMPO E NO ESPAÇO… A Terra pode ser considerada um sistema fechado, pois ocorrem trocas significativas de energia com a sua vizinhança mas não de matéria; por isso, nenhuma água (seja no estado sólido, líquido ou de vapor) entra ou sai do nosso planeta. A complexa evolução da Terra desde a sua formação há cerca de 4570 milhões de anos, conduziu a condições de pressão e temperatura à superfície que na atualidade, curiosamente se encontram muito próximas das condições de transição entre os três estados físicos com que a água aqui ocorre. Deste modo, pequenas variações da pressão atmosférica e/ou na quantidade de energia térmica ganha ou perdida num dado momento em qualquer um dos reservatórios naturais onde a água se encontra armazenada (e.g. oceanos, água subterrânea, rios ou calotes polares), são suficientes para induzir transições de fase desta água e levar à sua circulação convectiva, promovendo transferências entre os vários reservatórios. A água à superfície do nosso planeta encontra-se por isto em constante movimento, num complexo sistema de transferências energéticas, durante o qual a água circula dos oceanos para a atmosfera e de novo para os oceanos passando pelos continentes, num processo contínuo denominado CICLO HIDROLÓGICO.

ΔS = P - (R + G + E + T)

ΔS – Variação do volume armazenado P – Precipitação R – Escoamento superficial G – Escoamento subterrâneo E – Evaporação T - Transpiração Aplicação

E com a água faz-se luz! A sobrevivência do Homem esteve sempre dependente da existência de água; ao longo da história da Humanidade procurou fixar-se junto das principais fontes deste bem precioso e muitas civilizações viviam na dependência dos principais rios. As represas de água mais antigas que se conhecem localizavam-se no Egipto, no Médio Oriente e da Índia e tinham como objetivo principal armazenar água para enfrentar períodos de seca e escassez de água. Atualmente o desenvolvimento tecnológico e a engenharia permitem transformar a energia potencial gravítica de uma massa de água em movimento, possuidora por isso de energia cinética, e esta em energia elétrica (hidroeletricidade). A energia hídrica está assim associada à energia do escoamento superficial da água nos rios, ou seja, ao longo de uma linha de corrente, na qual cada ponto do percurso se encontra a uma determinada cota z que representa a energia potencial de posição em relação ao campo gravítico. Nas barragens de produção de energia hidroelétrica, a energia cinética inerente ao fluxo constante da água em movimento (fluxo esse que é produzido pela conversão da energia potencial da água no reservatório ao cair ao longo de um desnível ou queda de água) é transformada em trabalho que induz o movimento rotacional de turbinas hidráulicas colocadas nas barragens num nível inferior. As turbinas em movimento vão então acionar um gerador elétrico onde parte da energia mecânica da água que atinge as turbinas é transformada em energia elétrica. Assim a potência (P) gerada por uma massa de água num desnível ou queda de água, ou seja a quantidade de energia gerada por unidade de tempo, é diretamente proporcional à altura (h) e ao caudal (Q), isto é, o volume de água escoado numa secção reta, por unidade de tempo:

P = ?Qhg

Se a energia potencial (Ep = mgh) depende da altura de queda da água, e se transforma integralmente em energia cinética (Ec = mv2/2) que é diretamente proporcional ao quadrado da velocidade da massa de água em movimento, a água atinge as turbinas com velocidade

v = √2gh . Como o caudal é dado por Q = vA, onde A é a área da secção reta do canal adutor, a potência gerada por uma massa de água vem:P – Potência (Watt – Joule/segundo) h – Altura do desnível/queda de água (m) Q – Caudal (m3/s) ? - Densidade da água g – aceleração da gravidade (m/s2) P=ρA√2g³h³ o que mostra claramente que ela depende apenas da altura de queda da água em relação às turbinas e da área do canal adutor, pois as restantes variáveis da equação podem ser consideradas constantes no caso das barragens. A maior barragem de produção elétrica no mundo, a de Itaipu, situa-se na fronteira entre o Brasil e o Paraguai, no Rio Paraná uma linha de água que se estende por cerca de 2570 km e apresenta caudais máximos de 16 000 m3/s. Em 2009 esta hidroelétrica, com 196 m de altura, gerou 91.6 TWh, o equivalente ao total de energia elétrica consumida no Paquistão no mesmo ano... O Cientista

JOSÉ PINTO PEIXOTO (1922 - 1996) José Pinto Peixoto nasceu na aldeia da Miuzela, no distrito da Guarda e viria a tornar-se um dos mais influentes cientistas do século XX na área das ciências atmosféricas. A importância dos seus estudos relacionados com a física da atmosfera em geral e do ciclo global de água em particular, levou a que fosse considerado por alguns dos grandes cientistas da sua área como o “maior especialista mundial do ciclo hidrológico global”. Os seus trabalhos permitiram avanços fundamentais na compreensão das Ciências da Atmosfera, tendo os seus modelos de circulação global da atmosfera contribuído decisivamente para os estudos de previsão climática ou para o conhecimento da formação das regiões áridas. Muita da investigação mais importante por ele efectuada sobre a Teoria da Circulação Global da Atmosfera foi realizada no Massachusetts Institute of Technology (MIT). As suas ligações a este instituto iniciam-se a partir de 1954, no âmbito de uma bolsa de estudo de pós-graduação da Academia de Ciências de Lisboa. É nesta altura que entra na equipa liderada por Victor Starr a qual viria a ser responsável pelos primeiros estudos sistemáticos da circulação global da atmosfera. Para além de Pinto Peixoto, este grupo integrava outros cientistas que influenciaram decisivamente os estudos sobre o clima, nomeadamente Abraham Oort (com quem viria a escrever Physics of Climate uma das obras de referência em clima a qual constitui uma síntese dos trabalhos realizados cientista português participou ao longo da sua vida) e Edward Lorenz (que seria conhecido principalmente pelos seus contributos sobre o caos e o estabelecimento do chamado efeito borboleta). Nesta equipa Pinto Peixoto fica responsável pelo ciclo da água na atmosfera, tendo produzido os primeiros mapas de transporte global da água pela circulação atmosférica; a elaboração destes mapas foi possível devido à enorme quantidade de dados que começaram a ser gerados pelo actual sistema de observação contínua da atmosfera implementado em 1958 durante o Ano Geofísico Internacional. Ao longo da sua vida académica, Pinto Peixoto mostrou ser um cientista completo, não se tendo fixado num único tema, efectuando investigação em áreas como Hidrologia, Clima, ou Termodinâmica. Os seus trabalhos eram apoiados em fortes conhecimentos matemáticos, o que não será de estranhar tendo em consideração que a sua primeira licenciatura em 1944 foi em Ciências Matemáticas; apenas em 1952 se licencia em Ciências Geofísicas, área em que se doutora em 1959, sempre pela Universidade de Lisboa. Cientista de uma cultura invulgar, não só na Física em geral, mas também nas Letras e na História leccionou disciplinas nas áreas da meteorologia e termodinâmica em diversas universidades nacionais e internacionais; foi o responsável pela introdução na Faculdade de Ciências de Lisboa das temáticas, por exemplo, da física das baixas temperaturas, da superconductividade ou da teoria da informação. Pinto Peixoto manteve sempre uma estreita ligação entre a investigação que desempenhava na Universidade e as suas funções de meteorologista que tinha, no recém-criado Serviço Meteorológico Nacional, onde trabalhou entre 1946 e 1969. O Conceito

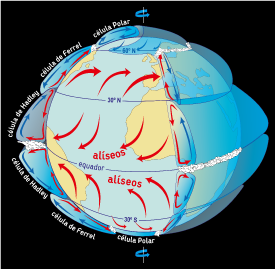

DA CIRCULAÇÃO GLOBAL ATMOSFÉRICA AOS VENTOS  O planeta Terra é diariamente atingido com radiação proveniente do Sol a qual ao atingir a sua superfície provoca o seu aquecimento. Contudo esse aquecimento da superfície terrestre não é uniforme. As regiões localizadas em torno do equador (aproximadamente entre os 0º e os 30º de latitude, norte e sul) apresentam um balanço positivo entre a energia solar absorvida e a radiação emitida pela superfície; isto é, tendem a aquecer. Quanto às regiões localizadas mais junto dos pólos, elas apresentam um balanço negativo, tendendo a arrefecer. Este é um esquema simples do que aconteceria caso não existissem processos contínuos de transferências de energia entre as zonas equatoriais e os pólos. Esses processos ocorrem nos oceanos e na atmosfera constituindo a denominada Circulação Global Atmosférica. O ar torna-se menos denso com o aumento da temperatura e, também, da humidade. Deste modo, com as temperaturas mais elevadas e com uma taxa de evaporação maior, cria-se uma região de baixas pressões nas zonas intertropicais, provocada pelos movimentos ascendentes do ar menos denso; ao ascenderem estas massas de ar deslocam-se para norte e sul. Ao longo desse deslocamento arrefecem e perdem humidade, devido à intensa precipitação que ocorre nas regiões em torno do equador. As massas de ar vão assim aumentando de densidade induzindo zonas de altas pressões causadas pela sua descida, em torno das latitudes próximas dos 30º norte e sul. Estas circulações atmosféricas em torno do equador designam-se por células de Hadley.  Mas este é um processo convectivo e estes movimentos das massas de ar que ocorrem em altitude induzem ventos superficiais que se deslocam na zona tropical norte e sul, em direção ao equador, os quais se designam por ventos alísios. Entre os pólos e os 60º de latitude norte e sul encontram-se as células Polares, onde o ar mais quente e húmido é ascendente aos 60º e descendente nos pólos; aqui os ventos superficiais deslocam-se dos pólos em direção às regiões de menor latitude. Finalmente, em ambos os hemisférios, entre os 30º e os 60º de latitude, intermédia em relação às Células Polares e de Hadley, encontram-se as células de Ferrel; nesta célula, os ventos superficiais deslocam-se em direção às regiões de maiores latitudes. No entanto, numa Terra em permanente movimento de rotação, a circulação das massas de ar é mais complexa, sendo as direções do vento à superfície afetadas por 3 forças. A primeira é o gradiente de pressão do ar, que leva a que o vento se desloque dos locais de maior pressão para os de menor. A segunda é a força de Coriolis induzida pela rotação da Terra, atuando para a direita do movimento no hemisfério norte, e para a esquerda no hemisfério sul. A influência desta força é importante apenas para deslocações longas, em tempo e espaço, e para corpos que não estejam agarrados à superfície terrestre, pelo que a circulação atmosférica é fortemente influenciada por ela. A terceira força é a fricção, que diminui a velocidade do vento, sendo influenciada, por exemplo, pela vegetação, topografia ou edifícios. Quando combinadas estas 3 forças, levam a que a direção dos ventos dominantes à superfície da Terra tenda a apresentar um ângulo de 45º em relação às linhas isobáricas (i.e. linhas de igual pressão), desviando-se no sentido dos ponteiros do relógio no hemisfério norte, e no oposto no hemisfério sul. Aplicação

ENERGIA AO SABOR DO VENTO… Energia Eólica é a energia que é convertida a partir da energia cinética da deslocação das partículas gasosas – o vento. Esta deve o seu nome a Éolo, deus dos ventos na mitologia grega. A ação do vento tem sido utilizada ao longo dos tempos, desde os barcos à vela e os moinhos de vento aos modernos aerogeradores. No caso destes últimos, a energia do vento é convertida em energia elétrica que é posteriormente utilizada, por exemplo, em diversos equipamentos existentes nas nossas casas. A Energia Eólica é, na realidade, um produto da energia solar. Como o Sol aquece a superfície terrestre de forma desigual, desencadeiam-se vários processos de transferência de energia pelo planeta, que resultam desse desequilíbrio. Um desses processos é a Circulação Global Atmosférica, que coloca enormes massas de ar em movimento, num padrão mais ou menos bem definido, a uma escala temporal alargada, a nível planetário. A uma escala mais local e, temporalmente menor, existem outros processos relacionadas, também eles, com o aquecimento desigual da superfície terrestre; são eles, por exemplo, a brisa marítima/terrestre e a brisa de montanha/vale que dão-se em ciclos diários. Existem 2 tipos de aerogeradores, os de eixo vertical e os de eixo horizontal; estes últimos, que são os mais comuns, apresentam o seu eixo segundo a direção do vento. Os aerogeradores veem equipados com 1 torre, que pode ultrapassar a centena de metros de altura para captar a energia do vento, 1 rotor de 3 pás, entre 25 e 45 metros cada, e a nacelle que abriga o gerador e que pode girar, de forma a colocar as pás favoravelmente orientadas ao vento. A energia cinética do vento é, em primeiro lugar, aproveitada para fazer mover as pás que, estando ligadas a um gerador elétrico através de um eixo, convertem essa energia mecânica em energia elétrica. A energia do vento consegue ser aproveitada nas pás, porque estas funcionam como asas; estas são curvadas, fazendo com que a velocidade do vento aumente no lado curvo, tendo como consequência, a sua movimentação nesse sentido. Essa conversão dá-se através de uma indução eletromagnética, que ocorre quando o eixo faz girar um magneto. Esse movimento vai provocar a variação do fluxo campo magnético produzido pelo magneto numa bobine próxima, induzindo nessa bobine uma corrente elétrica – energia elétrica. A potência produzida por cada aerogerador depende da dimensão das pás, da velocidade do vento e da altura da torre; varia desde os cerca de 10 kw para aerogeradores de pequena dimensão aos 2 a 3 Mw para os de grande porte. Atualmente, a Energia Eólica representa cerca de 20% da energia elétrica produzida em Portugal. Para o futuro, estudos apontam que uma pequena percentagem da energia dos ventos a grandes altitudes (jet stream), seriam suficientes para cobrir todas as necessidades elétricas mundiais. A Cientista

MARIE CURIE (1867 – 1934) Durante toda a Idade Média inúmeros Alquimistas tentaram persistentemente e sem nunca o conseguir, transformar determinados elementos noutros (em especial o chumbo em ouro); era a chamada transmutação dos metais. Se os insucessos levaram a crer na impossibilidade de tal processo, na transição dos séculos XIX para o XX percebeu-se que afinal, não só os metais mas muitos outros elementos se transformavam naturalmente uns nos outros; e tudo começou por um acaso. Em 1896, devido às condições atmosféricas que o impediam de trabalhar, Antoine Henri Becquerel guardou sais de urânio junto a chapas fotográficas numa gaveta durante 5 dias. Ao retirá-las da gaveta verificou com surpresa que as chapas tinham uma impressão e que esta só poderia ter sido causada pelos sais. Enquanto os primeiros passos na descoberta da radioactividade estavam a ser dados, na Polónia emergia uma jovem cheia de talento, Maria Skłodowska. Apesar de lhe ser negada a entrada na Universidade de Varsóvia, por ser exclusiva para homens, frequentou aulas numa universidade clandestina associada ao movimento Positivista, enquanto trabalhava para suportar os seus estudos. Muda-se finalmente para Paris onde acaba por se licenciar em Física. Fascinada com a descoberta de Becquerel, inicia uma série de experiências num laboratório improvisado e mal equipado, que a levaram a conhecer e colaborar com o marido Pierre Curie (passando então a ser conhecida por Marie Curie). Concluem então que esta radiação não provinha do mineral (uraninite), mas efectivamente do átomo do elemento Urânio; criam então o termo radioactividade para designar este fenómeno. Esta descoberta conduziu o trio a ganhar o Prémio Nobel da Física em 1903. Quebrando várias barreiras sexistas da sociedade de então, torna-se na primeira professora e directora de um laboratório de Física da Universidade de Sorbonne e dedica-se a descobrir e individualizar dois novos elementos: o Rádio e Polónio. Marie Curie, que usava toda a sua minúcia e criatividade na investigação, mantinha sempre no bolso da bata um tubo de ensaio com Rádio, o elemento que a fascinava, Extremamente convicta de que poderia auxiliar outras pessoas, focou a sua atenção durante a 1ª guerra mundial na aplicação da radiação no tratamento de ferimentos, levando consigo equipamentos móveis de raios-X para as linhas de combate. Após esta experiência dedicou-se a angariar fundos para construir o Instituto do Rádio, com o intuito de investigar as aplicações da radioactividade à saúde. O Conceito

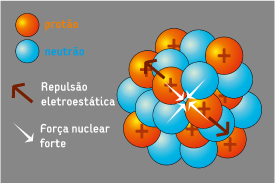

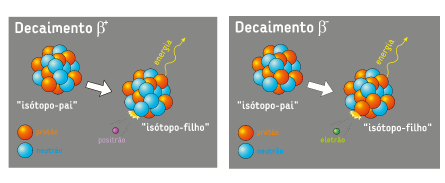

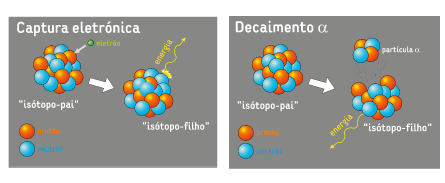

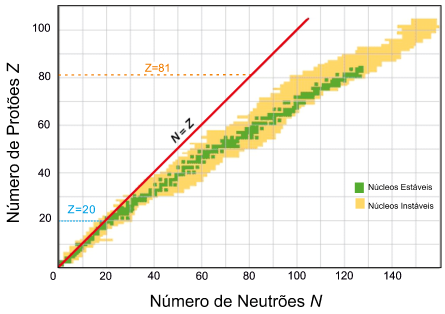

DA FORÇA NUCLEAR FORTE À RADIOATIVIDADE; DATANDO COM ENERGIA  Para compreender a radioatividade é preciso compreender o átomo. O átomo é constituído por um núcleo, de dimensões muito reduzidas, onde se encontram protões e neutrões (nucleões), rodeados por uma nuvem de eletrões. Os protões são partículas com carga positiva, os eletrões negativa e os neutrões não têm carga. Deste modo, devido às forças eletromagnéticas geradas por diferenças de carga, os eletrões são atraídos pelo núcleo.  No entanto, em muitos elementos químicos, é possível estarem várias dezenas de protões no núcleo, ocupando um espaço diminuto. Que força poderá ser superior à força de repulsão de partículas de igual carga? Esta força é fundamental, pois é ela a responsável pela elevada energia associada ao decaimento radioativo! A massa de um neutrão ou protão é de aproximadamente 1,008 unidades de massa atómica (u). Pensando, por exemplo, no elemento químico Rádio, o seu isótopo¹ mais comum tem 88 protões e 138 neutrões, mas apenas uma massa atómica de 226.02u, quando deveria ser de 227.8u ((88 + 138)x1,008). Esta diferença, entre a massa total do núcleo e a soma das massas individuais das partículas que o constituem (i.e. protões + neutrões), corresponde à massa que é transformada na energia necessária para manter unidos os neutrões e os protões no núcleo (E=mc2 a energia é igual ao produto da massa pelo quadrado da velocidade da luz no vácuo), induzindo a força nuclear forte. A eficácia desta força é fortemente dependente da distância entre as partículas e, de um modo geral, o aumento do número atómico leva a uma maior aproximação entre os nucleões. Contudo, os protões tendem a repelir-se pois exibem cargas elétricas iguais, existindo por isso um limite mínimo de distanciamento entre eles, para que o átomo seja estável. A inclusão de mais neutrões no núcleo contribui para manter o afastamento entre os protões. Deste modo, à medida que o número atómico aumenta, o número de neutrões é sempre superior ao dos protões. No entanto, há um limite a partir do qual já não se alcança estabilidade com a inclusão de mais neutrões, como sejam todos os isótopos dos elementos químicos com número atómico superior ao do bismuto (Z=83). Nestes casos, para alcançar a estabilidade, o núcleo irá sofrer decaimento, o que se traduz numa transmutação de elemento químico e na libertação de energia sob a forma de radiação – radioatividade. Esta alteração pode terminar ao final do primeiro ciclo de decaimento ou poderá repetir-se diversas vezes até esse átomo atingir a estabilidade. Chama-se isótopo-pai ao átomo que decai e isótopo-filho ao que resulta do decaimento.   A atividade radioativa de uma determinada substância vai diminuindo com o tempo, de forma exponencial, pois a cada tempo de semi-vida, a concentração inicial de isótopos-pai diminui para metade, e assim consecutivamente, até que todos os núcleos instáveis terem decaído. Este processo é aleatório, ou seja, a cada tempo de semi-vida, cada isótopo-pai pode decair para estável ou manter-se instável. Uma vez que o decaimento é constante para cada isótopo, torna-se possível saber a idade de vários materiais, através da análise das razões isótopo-pai e isótopo-filho.  1 Isótopos são espécies do mesmo elemento químico que partilham o mesmo número atómico, isto é, têm o mesmo número de protões, mas massa atómica distinta, pois varia o número de neutrões Aplicação

Partindo a loiça toda... neste caso o Urânio! A energia nuclear corresponde actualmente a cerca de 6,4% do consumo energético mundial, traduzindo-se em aproximadamente 13,4% da electricidade mundial produzida. O maior produtor deste tipo de energia é os Estados Unidos da América, seguido pela França e pelo Japão. Através da quebra de ligações entre partículas do núcleo dos átomos, mantidas por forças nucleares fortes, é possível obter energia. Existem diferentes mecanismos de decaimento de um núcleo, sendo que uns são naturais e outros induzidos pelo Homem; o de fissão nuclear utilizado nos reactores nucleares actuais para obter energia é um deles. Neste processo, um núcleo de um isótopo instável, por exemplo o Urânio-235, é bombardeado por uma partícula, que pode ser um neutrão. Esta partícula ao colidir com o núcleo pode induzir a sua fissão (quebra), originando dois núcleos instáveis de outros elementos químicos com menor número de massa, alguns neutrões e energia sob a forma de radiação, resultante da perda de massa. Os neutrões gerados nesta colisão poderão agora colidir com outros núcleos instáveis, voltando a ocorrer fissão e libertação de energia num processo de reacções em cadeia. Quando a colisão de um neutrão com um núcleo instável não produz a sua fissão, ele pode ser capturado por esse núcleo e esse átomo passa a um novo isótopo de número de massa superior, geralmente instável. A maior parte dos produtos resultantes da fissão nuclear são radioactivos, como o plutónio-239, continuando a alimentar o processo, numa reacção em cadeia sem adição de novo combustível. Existem poucas substâncias capazes de alimentar este tipo de reacção em cadeia, sendo que o Urânio é o único elemento natural com isótopos apropriados, denominados por isótopos fisseis.

Cerca de 99,2% do Urânio existente na natureza encontra-se sobre a forma de 238U, que embora sendo radioactivo não é físsil. Apenas 0,7% do urânio natural é físsil sobre a forma do isótopo 235U, mas é necessária uma concentração de 3 a 5% para que possa ser utilizado num reactor nuclear; através da separação e concentração deste isótopo produz-se o chamado urânio enriquecido. No entanto, nem tudo é vantajoso neste tipo de Energia. Apesar do elevado rendimento energético, os resíduos produzidos não são inertes mantendo-se radioactivos por períodos de tempo muito longo, a localização das centrais nucleares está dependente da proximidade de água para arrefecimento dos reactores e, devido à perigosidade por libertação de radiação, estas só deverão ser construídas em locais geologicamente estáveis. Uma vez que ocorra um acidente grave, como no caso de Chernobil (Rússia) ou Fukushima (Japão), não só ocorre a morte imediata de dezenas de pessoas, como a curto prazo milhares de pessoas são profundamente afectadas podendo vir a morrer, perdurando os efeitos nefastos das radiações libertadas ao longo de gerações. Arte e Espetáculos  "Velocipedia" por Projecto EZ (pt)

“EZ veículos” apresenta-se como um projeto de veículos a pedais. Veículos onde a criatividade e a originalidade dão a quem pedala um prazer incrível. Nasceu do gosto pelas bicicletas, influenciado pela vertente circense e artística do seu criador e por um experimentar constante de materiais e ideias que tem de ter solução! “3 Atores, 3 veículos…1 imaginário...!” Três personagens com três veículos dão a volta ao mundo. Mundo esse que todos nós temos. Deambulam interagindo com o público, numa vertente cómica e direta numa vertente de animação permitindo circular nos seus veículos quem queira e se apresente em condições para tal. EZ marca a diferença e não nos deixa indiferentes... "Velocipedia é a arte de andar em velocípede e tudo que diz respeito aos velocípedes (evolução, desporto, indústria, etc.).(...)Pedalar e divertir é a chave deste projeto. EZ apresenta-se com veículos a pedais, onde a diferença e a audácia de ideias dão vida a três personagens que deambulam por aí. Viajam sem destino certo mas dão a volta ao mundo. Mundo esse que todos nós temos. O mundo da magia, o mundo da loucura, o mundo da boa disposição... Um projeto com e sob rodas." FICHA TÉCNICA E ARTÍSTICA website: facebook.com/ezveiculos

"Tumbala" por Tumbala (pt)

"Nova performance musical com máquinas de cena. Máquinas de percussão em tubos de PVC e instrumentos de sopro. Música latin funk, em formato de fanfarra ambulante.

Um grupo de oito personagens fantásticos armados com máquinas estrambólicos assalta as ruas com uma performance musical, de interacção com o público, espalhando a desordem, a alegria e a festa." FICHA TÉCNICA E ARTÍSTICA website: www.tumbala.pt.am

"Factor E" por PIA Projectos de Intervenção Artística (pt) com Jon Beedell/Desperate Men (uk)

No âmbito da 7ª edição do Festival “Ciência na Rua”, a PIA lança o desafio a Jon Beedell, da companhia Inglesa Desperate Men, para a criação de um site specific tendo o tema da Energia como essência. Criado em Residência Artística no Convento das Maltezas de Estremoz, “Factor E” trata-se de um espectáculo de clown/teatro físico que deixa como mensagem um alerta para o facto que, mesmo para uma simples rotina no nosso dia-a-dia, a energia que geramos nunca é suficiente face àquela que consumimos. Jon Beedell assina a Encenação e Dramaturgia, a PIA, com Pedro Leal e Helena Oliveira, faz o acompanhamento desta que é uma criação colectiva, e à qual se juntam os intérpretes João Paulo Reis, Pedro Charneca, Rui Ferreira e Telma Pinto.

FICHA TÉCNICA E ARTÍSTICA website: www.piacrl.com

"Stringendo" por Eborae Mvsica (pt)

A Orquestra de Cordas do Conservatório Regional de Évora - Eborae Mvsica foi criada durante o ano lectivo de 2005/2006, tendo feito a sua primeira apresentação na Audição da Páscoa, no dia 1 de Abril de 2006.

Constituída por iniciativa dos alunos e professores com o objectivo de promover a prática de Conjunto, estabelecer e reforçar as relações de partilha e cooperação a nível musical com reflexos na qualidade de interpretação instrumental. Tem participado nas Audições e numerosos Concertos em Évora e em várias cidades em Portugal e Espanha. Neste Concerto juntam-se às Cordas alguns instrumentos de Sopro, assim como os solistas em guitarra. É dirigida pelo Professor Luís Rufo. website: eborae-musica.org

"Charanga" por Circolando (pt)

"Espectáculo poético e visual, Charanga parte de dois objectos simbólicos, a bicicleta e a fanfarra. Parte das entranhas da terra para desejar os elementos ali ausentes: luz, ar, viagem... Procura a solidão, a nostalggia dos mineiros... e inventa para eles um sonho de criança. Com altura de luz, negros recantos, É toda, lá por dentro, povoada De sonhos, fantasmas, de espantos" Teixeira de Pascoaes

FICHA TÉCNICA E ARTÍSTICA website: www.circolando.com/charanga.html

"Sopro" por Armazém 13 (pt)

"O ser é, ao princípio, metade fera, metade floresta; Mas o ar quer tornar-se Espírito, e então o homem surge." O elemento ar é simbolicamente associado ao vento, ao sopro. Representa o mundo subtil intermediário, entre o céu e a terra, o da expansão, que é preenchido, dizem os chineses, pelo sopro ( K'i ), necessário à subsistência dos seres.

FICHA TÉCNICA E ARTÍSTICA website: armazem13.cia-adn.com/blog/

BARDOADA - Grupo do Sarrafo

"Arruada" por BARDOADA - Grupo do Sarrafo (pt)

O Grupo do Sarrafo é um grupo de percussionistas de Pinhal Novo, que utiliza, na construção do seu imaginário rítmico popular, instrumentos como Bombos, Timbalões e Caixas. A partir disto, preenche as suas atuações com muito boa disposição e vários momentos de interação com o público.

O Grupo tem vindo a desenvolver a sua atividade sobretudo através da participação em desfiles, corsos e espetáculos, realizando uma média de 40 atuações por ano - contando atualmente com cerca de 22 elementos, todos executantes de percussão. Os Bardoada nasceram em 1997, após uma ação de formação promovida pela Câmara Municipal de Palmela, tendo logo participado no FIG desse ano (o Festival Internacional de Gigantones de Pinhal Novo) uma festa que envolve vários grupos nacionais e estrangeiros de música e teatro de rua. Entretanto, 2001 é o ano em que o grupo consolida definitivamente a sua importância no contexto do Pinhal Novo - onde a Câmara Municipal de Palmela convida os Bardoada como parceiros na organização do FIG 2001, um reconhecimento que, de resto, vem alinhado com todo o apoio que a Autarquia vem dando ao grupo, quer na compra de instrumentos e dos uniformes, quer no transporte dos músicos.

FICHA TÉCNICA E ARTÍSTICA website: www.myspace.com/bardoada

|